Mencakup pengubahan seluruh huruf menjadi huruf kecil, adalah langkah penting dalam analisis sentimen review aplikasi. Dengan normalisasi, teks dari ulasan pengguna akan seragam dalam formatnya, mempermudah proses analisis dan klasifikasi. Dengan demikian, perbedaan huruf besar kecil tidak akan mempengaruhi hasil akhir, dan algoritma analisis sentimen dapat lebih efektif dalam mengidentifikasi pola dan sentimen yang mendasari ulasan pengguna. Ini adalah langkah awal yang penting dalam mempersiapkan data untuk proses analisis lebih lanjut.

2.3 Data Cleaning

Proses cleaning data, yang meliputi penghapusan tanda baca dan penggunaan stopwords dari Sastrawi. Dengan menghilangkan tanda baca, teks ulasan menjadi lebih bersih dan lebih mudah diproses oleh algoritma analisis. Selain itu, penggunaan stopwords dari Sastrawi membantu menghilangkan kata-kata yang umumnya tidak memberikan kontribusi signifikan terhadap pemahaman sentimen, sehingga meningkatkan akurasi dalam mengidentifikasi sentimen yang sebenarnya dalam ulasan pengguna.

2.4 Tokenization

Tokenization adalah tahap penting dalam analisis sentimen review aplikasi di mana teks ulasan dibagi menjadi unit-unit yang lebih kecil yang disebut token. Token dapat berupa kata, frasa, atau karakter terpisah, tergantung pada metode tokenisasi yang digunakan. Dengan tokenization, teks ulasan dapat dipecah menjadi bagian-bagian yang lebih terstruktur, memungkinkan analisis lebih lanjut seperti pembentukan model atau perhitungan statistik. Dengan memiliki teks yang sudah dipisahkan ke dalam token, proses analisis sentimen dapat dilakukan dengan lebih efisien dan akurat.

2.5 Stemming

Stemming dilakukan untuk mengubah kata-kata dengan imbuhan menjadi bentuk dasarnya, dengan asumsi bahwa makna kata tersebut tetap sama. Hal ini bertujuan untuk mempermudah pembobotan kata dalam proses analisis. Meskipun proses ini memerlukan waktu yang cukup lama saat dijalankan menggunakan Python, hal tersebut tergantung pada jumlah kalimat atau kata yang diproses dalam dokumen. Proses stemming menggunakan library NLP (Natural Language Programming) dalam bahasa Indonesia, yaitu Sastrawi. Penggunaan Sastrawi dipilih karena meskipun sederhana, library tersebut tetap dianggap berkualitas dan memiliki dokumentasi yang baik.

3. Pembobotan TF-IDF

Pembobotan TF-IDF (Term Frequency-Inverse Document Frequency) adalah teknik yang digunakan untuk mengevaluasi pentingnya suatu kata dalam sebuah dokumen dengan memberikan nilai bobot pada setiap kata tersebut. Metode ini telah menjadi favorit karena tingkat akurasinya yang tinggi, memungkinkan pembobotan kata dilakukan secara efektif dan efisien dengan hasil yang memuaskan. Dalam penelitian ini, penulis memanfaatkan sebuah library dalam bahasa Python yang menyediakan rumus TF-IDF, yaitu TfidfVectorizer.

4. Klasifikasi Nave Bayes Classifier

Dalam proses klasifikasi menggunakan NBC (Nave Bayes Classifier), pengklasifikasian dilakukan dengan memanfaatkan metode probabilitas dan statistik untuk menghasilkan akurasi klasifikasi dokumen yang telah diolah. Penelitian ini menerapkan algoritma Nave Bayes Classifier dengan menggunakan metode Multinomial Nave Bayes. Metode ini terbukti efektif dalam menghitung frekuensi kemunculan setiap kata dalam suatu dokumen, sehingga memungkinkan untuk melakukan klasifikasi dengan akurat. Multinomial Nave Bayes digunakan karena algoritma ini memiliki beberapa keunggulan, yaitu memiliki tingkat akurasi yang tinggi, mudah untuk diimplementasikan, memakan waktu komputasi yang rendah, dan error state yang minimum.[7]

5. Pembagian Data Train dan Data Test

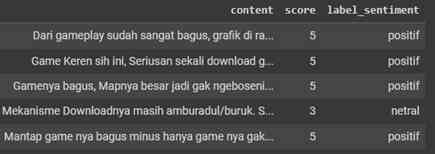

Dalam proses pembagian data menjadi data latih (training) dan data uji (test), dilakukan pembentukan model klasifikasi. Hal ini bertujuan agar informasi yang dihasilkan dari data pelatihan dan data uji dapat digunakan untuk memprediksi kelas data baru dengan akurasi yang tinggi. Dengan membagi data menjadi dua bagian ini, model klasifikasi dapat diuji dan dievaluasi keefektifannya dalam mengklasifikasikan data yang belum pernah dilihat sebelumnya.

6. Evaluasi

Pada tahap evaluasi, beberapa langkah dijalankan, di antaranya adalah pembuatan Confusion Matrix untuk mengevaluasi kinerja NBC (Nave Bayes Classifier). Langkah ini penting untuk mengukur Recall, Precision, Accuracy, dan F-Measure. Confusion Matrix membantu dalam memberikan gambaran yang jelas tentang seberapa baik model klasifikasi dapat mengklasifikasikan data dengan benar dan menganalisis performanya secara rinci.

7. Testing

Dalam tahap testing, saya menggunakan model klasifikasi yang telah dibuat untuk memprediksi apakah suatu kalimat termasuk dalam kategori negatif atau positif, berdasarkan pada data yang telah diproses sebelumnya. Langkah ini melibatkan memasukkan kalimat ke dalam model dan menganalisis keluaran prediksi yang dihasilkan. Proses ini memungkinkan untuk mengevaluasi seberapa baik model dapat membedakan antara kalimat negatif dan positif, serta mengukur keakuratannya dalam melakukan prediksi.